Willkommen auf der Astronomie-HomepageCCD-Kamera CCD-Beobachtung CCD-Astrofotografie SBIG-Kamera

Die Astronomie-Seite für Sternfreunde

Ihre Auswahl

| Sonnenfinsternis mit Photoshop | Bildbearbeitung mit Photoshop | Die Zeit aus dem Äther | CCD-Technik | Obstruktion | <| Sonne | Fernrohrschutzbau || Mitternachtssonne | Monitorkalibrierung | Berlebach | Vixen Sphinx | Zeichnen | Klappdachhütte |

Der Stuttgarter CCD-Workshop

ist eine gute Veranstaltung für die Einarbeitung in diese Materie: Direktlink

CCD-Technik für SternfreundeCCD-Kamera, CCD-Astrofotografie

Die digitaler Erfassung von Bildinformationen schreitet - nicht nur in der Astronomie immer weiter voran. Inzwischen steht auch für Sternfreunde eine große Auswahl an Digital-Kameras zur Verfügung. Durch den Einsatz verschiedener CCD-Chips mit unterschiedlichen Arbeitsweisen und durch die verschiedensten Softwareangebote wird das Gebiet der digitalen Astrofotografie immer unübersichtlicher. Dieser Beitrag will Sie schrittweise in die Grundlagen der CCD-Technik einführen.

1. Grundlagen der CCD Technik

2. Arbeiten mit einer CCD Kamera, Fehlerkorrektur an Bildern

3. Grundzüge der digitalen Bildbearbeitung

4. Nachtrag (Linearität von CCD-Kameras)

1. Grundlagen der CCD Technik

|

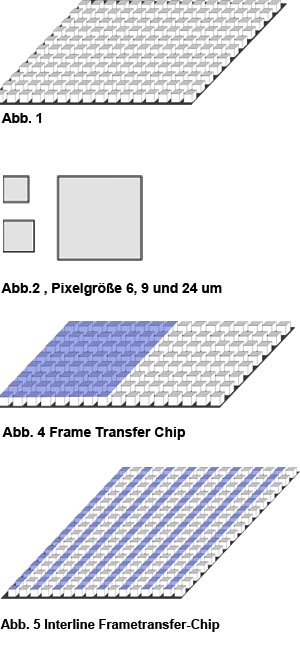

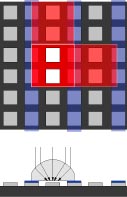

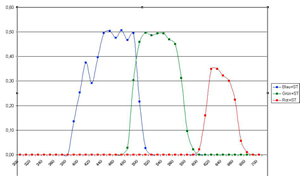

Abb. 6a/b Wirksame Fläche beim Interline-Transfer-Chip/ Linse auf dem Chip Auffallend ist, dass die optisch wirksame Fläche bei den Interline Frame Transfer -Chips besonders klein ist. Betrachten wir die Abb. 6a. Im 2-fach Binning-Mode (d.h. um die Empfindlichkeit zu erhöhen werden 2 x 2 Pixel zu einem zusammengefasst, später dazu noch mehr) sind die weißen Quadrate die wirksame lichtempfindliche Fläche. Dazwischen liegt eine Isolation (schwarz). Zudem tragen die maskierten Pixel (blau) nicht zur Empfindlichkeit bei. Die tatsächliche für die beiden Pixel verbrauchte Fläche ist rot und weiß umrandet. Zwei benachbarte Pixel sind ebenfalls angedeutet. Ein Vergleich der zwei weissen Flächen zur roten Fläche zeigt, dass nur ca. 25% der Fläche optisch wirksam sind. Um den Wirkungsgrad zu verbessern (man sagt hierzu in der Optoelektronik Quanteneffizienz = QE erhöhen) bringen die Chip-Hersteller Mikrolinsen auf (Abb. 6b). Diese Linsen bestehen aus einer optisch brechenden Flüssigkeit, die aufgetropft wird. Die Mikrolinsen sind also ausgehärtete Tröpfchen einer erstarrten Flüssigkeit. Erst durch diese Technik werden Interline Frame-Transfer-Chips für die Astrokameras interessant. Abb. 7 zeigt die Quanteneffizienz des Kodak KAI 2000 Chips mit und ohne Mikrolinsentechnik (Dieser Chip ist in der ST2000 von SBIG eingebaut). Die Wirkung der Mikrolinsen ist enorm. Hierdurch wird die Quanteneffizienz(QE) von ca. 8 auf ca. 45% gesteigert. Ein weiteres interessantes Phänomen ist in Abb. 7 zu erkennen. Die Abhängigkeit der QE von der Wellenlänge. Der gezeigte Sensor hat die max. Empfindlichkeit bei 480 nm mit ca. 44 %. Bei 680 nm, also bei der H-Alpha Linie beträgt die QE "nur" noch 22 %. Das "nur" steht deshalb in Anführungszeichen, weil es die besten Filme lediglich auf 4 ... 5 % bringen. |

Abb. 7 Quanteneffizienz mit und ohne Mikrolinsen. Eine wichtige Kenngröße für die CCD-Chips fehlt jetzt noch: die sogenannte Full Well-Capacity. In jedem Pixel wird Licht in elektrische Ladung umgewandelt. Die Lichtstrahlen werden im dotierten Siliziumkristall absorbiert und erzeugen elektrische Ladungen. Durch die umgebenden Elektroden (in Abb. 5 schwarz) wird eine Ladungssenke gebildet, die die entstehenden Elektronen festhält. Irgendwann ist die Ladungssenke voll; wenn jetzt weiteres Licht auf die aktiven Pixel fällt, werden noch mehr Elektronen freigesetzt. Diese laufen dann in andere Pixel über. Diesen Effekt nennt man Blooming. Das Auslaufen der Pixel - der Blooming-Effekt - kann verhindert werden, wenn beim Herstellungsprozess zwischen den einzelnen Pixeln eine Potentialsperre aufgedampft wird. Diese Sperren vermindern aber die Empfindlichkeit je nach Chip um bis zu 30%. Die Full Well-Capacity gibt nun an wie viele Elektronen in einem Pixel aufgenommen werden können bevor er ausläuft. Die Anzahl der Elektronen ist abhängig von der Größe der Pixel und liegt zwischen 20 000 und 200 000. Abb. 3 verdeutlicht diesen Zusammenhang. Während beim 24 µm Pixel der Wert bei 180 000 Elektronen liegt, liegt er beim 6 µm Pixel bei 20 000 Elektronen. Diese Größe ist ein direktes Maß für die Empfindlichkeit der Kamera. |

1.2 Auslesen des Sensors

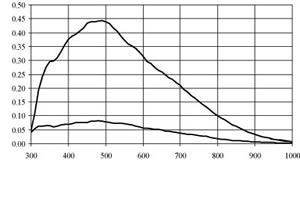

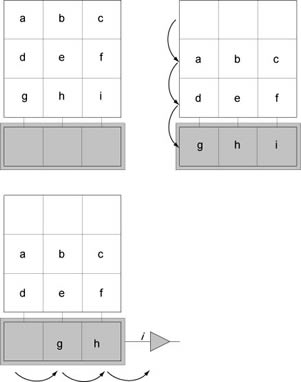

Abb. 8 Auslesen des Chips Solange Licht auf den Sensor fällt, steigt die Zahl der Elektronen in den einzelnen Pixeln linear an. Am Ende der Belichtung müssen die Elektronen jedes einzelnen Pixels gezählt (registriert) werden. Wie in Abb. 8 gezeigt wird, werden zuerst die Elektronen einer ganze Pixelreihen nach unten verschoben. Dann werden die Elektronen pixelweise nach rechts verschoben. Bevor die Elektronen auf einen Rechner übertragen werden, werden sie verstärkt, digitalisiert und für die Darstellung auf dem Monitor wieder dem richtigen Bildelement zugeordnet. Dieser Vorgang ist recht kritisch und verläuft bei keinem Kamerahersteller fehlerfrei. Wird das Bild sehr schnell ausgelesen besteht die Gefahr, dass Elektronen verloren gehen oder nicht schnell genug nachkommen und dann anderen Pixeln zugeordnet werden. Wird das Bild zu langsam ausgelesen, gehen Elektronen verloren, weil die Isolation zwischen den Pixeln nicht 100%ig ist. Das Signal wird also auf jeden Fall verfälscht. Das Streuen des ausgelesenen Wertes um den wirklich wahren Wert wird Rauschen genannt. Das speziell beim Auslesen des Sensors entstehende Rauschen wird Ausleserauschen oder read out noise genannt. Diesen Wert geben Kameraherstellern in den technischen Unterlagen an. Er liegt durchschnittlich im Bereich von 10 ... 100 Elektronen pro Pixel. Welche Möglichkeiten es gibt, das Rauschen zu reduzieren wird später besprochen. |

1.3 Mechanische und elektronische Komponenten der Kamera

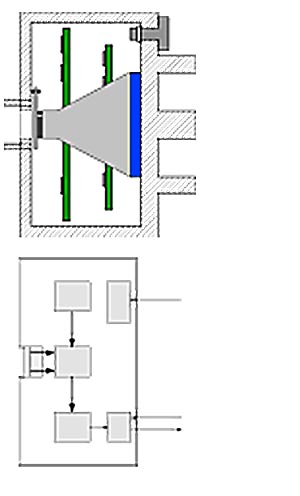

Abb. 9 Mechanische Komponenten dr Kamera Abb. 10 Elektronische Komponenten der Kamera In Abb. 9 sehen wir die wichtigsten Komponenten der CCD-Kamera. In der Mitte vorne befindet sich der CCD-Chip, welcher durch ein Fenster geschützt ist. Der Chip ist mit dem Peltierelement durch Kühlfinger verbunden. Das Peltierelement wird für die Kühlung des Chips verwendet. Der Peltiereffekt ist eine thermoelektrische Erscheinung, die bei einem Stromfluss an der Grenzfläche zweier Leiter auftritt. Der Effekt tritt bei Materialien, wie z.B. Kupfer/Halbleiter/Keramik, besonders deutlich hervor und erlaubt den Einsatz als Heizung oder als Kühlung. Die kalte Seite des Pelitierelements wird mit dem CCD-Sensor verbunden. Die auf der anderen Seite entstehende Wärme wird über Kühlrippen nach außen abgeführt. Zur weiteren Kühlung kann ein Ventilator zugeschaltet werden. Damit sich kein Frost auf dem Chipfenster niederschlägt muss der Innenraum sehr trocken sein. Alternativ verhindert auch ein Vakuum den Niederschlag von Frost. Je nach Ausführung ist ein mechanischer Verschluss, ein kleiner zweiter Chip für die Nachführung der Kamera, eine Steckhülse oder ein Gewindeanschluss für das Teleskop vorhanden. In dem verbleibenden Platz wird die Elektronik untergebracht. Für den Betrieb der Kamera ist eine Spannungsversorgung und ein PC notwendig. Angesteuert wird die Kamera über die USB-Schnittstelle bzw. ältere Modelle über die parallele Schnittstelle. Für den Betrieb des Chips befindet sich auf der Platine ein Timer (Abb. 10). Das vom Timer gelieferte "Clock"-Signal wird zum Löschen, für die Ermittlung der Belichtungszeit und für das Auslesen des Chips (Abb. 10) verwendet. Beim Auslesen wird das einzelne Pixelsignal zuerst verstärkt. Daran anschließend wird es digitalisiert und der digitale Wert über eine Schnittstelle an den PC geschickt. |

1.4 SoftwareUnter Software werden diejenigen Programme verstanden, die sich auf dem PC befinden.

Also keine Programme die z.B. den Mikrocontroller in der Kamera steuern.

Die Software hat primär die folgenden Aufgaben:

|

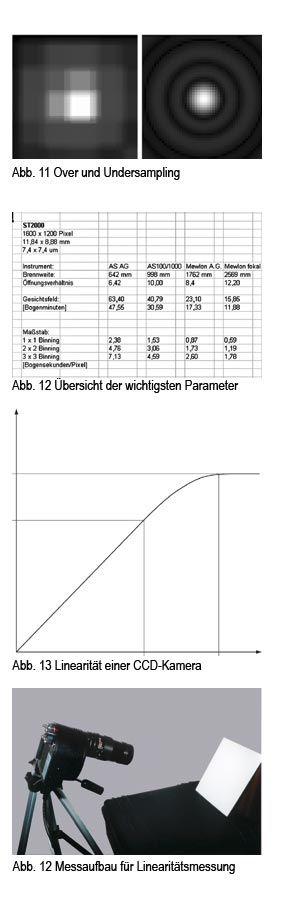

1.5 Hinweise zur Auswahl der Kamera

Wer in die CCD-Technik einsteigen möchte, hat üblicherweise schon ein Teleskop und eine Montierung. Genauso gibt es Vorlieben, welche Objekte beobachtet werden sollen. Es gilt also für die Ausrüstung und für die eigenen Neigungen eine passende Kamera auszuwählen. Dabei sind folgende Parameter zu beachten:

Die Grösse des Gesichtsfeldes ist abhängig von der Chipgrösse und der Brennweite des Teleskops. Sie ist nicht abhängig von der Öffnung oder dem Öffnungsverhältnis. Die Grösse des Gesichtsfeldes berechnet sich nach Formel 1.

Ein Beispiel: Bei einem Instrument mit 1000 mm Brennweite und einer Chipgrösse von 12 x 9 mm beträgt das Gesichtsfeld (3438 x 12 mm)/1000 mm = 41 x 31 Bogenminuten. Die Verhältnisse sind linear, d.h. bei 2 m Brennweite ist das Gesichtsfeld nur noch halb so gross! Eine weitere wichtige Kenngröße ist die Auflösung der Kamera. Diese kann auch mit Formel 1 berechnet werden. Anstatt der Kantenlänge des Chips wird die Pixelgröße z.B. 0,0074 mm eingesetzt und das Ergebnis mit 60 multipliziert um von den Bogenminuten auf die Bogensekunden zu kommen (3438 x0,0074 mm)/1000 mm x 60 = 1,52 Bogensekunden. Bei der Auflösung der Kamera ist zu beachten, dass das Auflösungsvermögen der Kamera nicht besser ist, als die Auflösung des Teleskops. Warum?

Fällt das Beugungsscheibchen genau auf einen Pixel, ist die Empfindlichkeit optimal ausgenutzt. Das gesamte Licht eines Sternes fällt auf einen Pixel. Dafür sind die Sterne eckig und es fehlen Grauanteile im Bild: Dies wird auch Undersampling genannt. Ist nun die Brennweite des Teleskops so gewählt, dass das Beugungsscheibchen z.B. auf 20 Pixel fällt, so entsteht ein Grauverlauf des einzelnen Sterns und er wird schön rund. Die Kamera arbeitet aber sehr unempfindlich, weil sich das Licht eines einzigen Sterns nun auf sehr viele Pixel verteilt: Dies wird auch Oversampling genannt. Ist also das Auflöusungsvermögen der Kamera höher als das des Teleskops, so wird Empfindlichkeit und damit die erreichbare Grenzgröße herabgesetzt.

|

2. Arbeiten mit einer CCD Kamera, Fehlerkorrektur an Bildern2.1 Der Start am AbendDer Beobachtungsabend beginnt bei mir meistens ca. 1/2 Stunde vor Sonnenuntergang. Die Zeit bis es dunkel ist verwende ich für folgende Aufgaben: |

2.2 Die BildfehlerAbb. 15 Fehler eines Pixels

Im ersten Teil wurden verschiedene Fehlerquellen erörtert. Vom Lichtquant, welcher am Pixel ankommt bis zur Darstellung am Monitor ist es ein langer Weg. Von der Information in einem Pixel interessiert uns im wesentlichen die Nutzinformation (siehe Abb. 15, grauer Anteil im Balken). Also der Teil der Sättigung des Pixels welcher von den einfallenden Lichtquanten hervorgerufen wurde.

|

Die Fehlerquellen hierbei sind: | |||

| Fehlerquelle | Ursache | Beseitigung | |

| 1 | Temperaturrauschen | Eigendynamik der Elektronen | Kühlung, Darkbild |

| 2 | Ausleserauschen des Verstärkers |

interne Elektronik | BIAS-Bild |

| 3 | Sensitivität

des Systems |

nicht homogener

Fertigungsprozess

des CCD-Chips, optische Fehler, Staub |

FLAT-Bild |

| Bei der Beseitigung dieser Fehler

handelt es nicht um Schritte der Bildbearbeitung im eigentlichen Sinne, sondern um eine Fehlerkorrektur. |

|||

zu 1:

Abb. 16: Darkbilder als Funktion der Temperatur Für die Beseitigung des Temperaturrauschens erstellt man neben dem Bild noch eine Aufnahme bei geschlossenem Verschluss mit der gleichen Belichtungszeit und bei der gleichen Temperatur. Weil dieses Bild bei Dunkelheit erstellt wird nennt man es auch DARK-Bild oder einfach DARK. Betrachten wir nochmals Abb. 15: Bei geschlossenem Verschluss fällt keine Nutzinformation an und eine evtl. vorhandene Überempfindlichkeit des Pixels spielt keine Rolle, da ja kein Licht auf die Pixel fällt. Wir erhalten also ein Bild das lediglich das Temperaturrauschen und das Ausleserauschen des Verstärkers enthält. Mit dem DARK beseitigt man also den orangen und den weissen Fehler-Anteil im Balken bei Abb. 15. Das Rauschen nimmt mit fallender Temperatur ab und halbiert sich etwa alle 6 °C. Abb. 16 zeigt die Wirkung der Kühlung bei einer SBIG ST2000. die Belichtungszeit betrug jeweils 5 min. Da dieser Fehler reproduzierbar ist, müssen die DARKs nicht unbedingt am Beobachtungsabend erstellt werden. Sonst wird die Hälfte der Beobachtungszeit für die DARKS verwendet. Empfehlenswert ist es eine DARK-Bibliothek in Abhängigkeit von Temperatur und Belichtungszeit anzulegen. Werden für das DARKs zusätzlich noch BIAS-Bilder (weisser Anteil) erstellt, so werden die DARKs skalierbar, d.h. ein 10-minütiges DARKs kann auch für eine 5-minütige Belichtung verwendet werden. |

zu 2:Erstellen wir wieder ein Bild bei geschlossenem Verschluss, aber mit der kürzest möglichen Belichtungszeit (theoretisch 0 s) so ist das Temperaturrauschen vernachlässigbar. Wir erhalten also ein Bild nur mit dem Fehler des Ausleseverstärkers (weisser Anteil). Dies Bild nennt man BIAS Bild. Natürlich bemerkt man hier auch defekte Pixel. Z.B. Pixel die überhaupt keine Elektronen aufnehmen (tote Pixel) oder Pixel die immer gesättigt sind (heiße Pixel). |

zu 3:

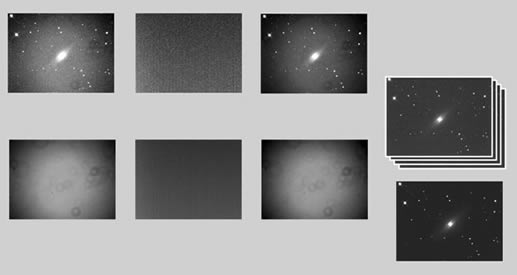

Abb. 17 In Abb. 17 zeigt das linke untere Bild ein sogenanntes Flat. Wäre das optische System ideal und die Empfindlichkeit aller Pixel gleich groß, könnte man auf diese Korrektur verzichten. Liegt aber z. B. ein Staubkorn im optischen System in der Nähe des Chips, so macht sich dieses anhand eines Ringes bemerkbar. Je schärfer der Ring ist, desto näher liegt die Verschmutzung am CCD-Chip. Zudem führt die Vignettierung zu einer nicht homogenen Ausleuchtung des Bildes. Die Fehler sind vielseitig und sollen hier nicht alle besprochen werden (z.B. die ungleiche Empfindlichkeit der einzelnen Pixel). Wichtiger ist, dass alle Fehler, die die Empfindlichkeit beeinflussen, korrigiert werden können! Am besten gelingt dies, wenn eine "absolut" homogene weisse Fläche mit dem Teleskop fotografiert wird. Bei einem idealen System müsste dann nach dem Abzug des BIAS und des DARKs wieder ein homogenes weisses Bild herauskommen. Dies ist aber nicht der Fall. Ein so erstelltes Bild nennt man Flatfield oder kurz Flat (Abb. 17 unten). Nicht ganz einfach ist es eine homogene Fläche zu finden. Ich benutze hierfür meist den Himmel während der Dämmerung wenn noch keine Sterne sichtbar sind. Dabei hat man allerdings nicht viel Zeit. Lediglich ein paar Minuten in der Abend- oder Morgendämmerung. Alternativen sind z.B. das erstellen einer Flatbox, die man für die Erstellung eines Flats vor das Teleskop montiert. Links für die Herstellung einer Flatbox finden Sie auf der Homepage www.astro-siggi.de. Die gesamte Korrektur des Rohbildes ist in Abb. 17 veranschaulicht. Vom Rohbild wird als erstes das DARK mit Hilfe einer Bildbearbeitungs-Software abgezogen (Es wurde bei der gleichen Temperatur und mit der gleichen Belichtungszeit wie das Rohbild erstellt). Da das erstellte DARK auch ausgelesen wurde, enthält dieses auch das Ausleserauschen des Verstärkers. Dieses wird gleich mit abgezogen. Man erhält so in der ersten Zwischenstufe ein um den Dunkelstrom und das Ausleserauschen korrigiertes Bild. Vom erstellten FLAT zieht man ebenfalls das DARK ab. Es handelt sich aber um ein anderes DARK als beim Rohbild, da das FLAT üblicherweise nur einige Sekunden belichtet wird. In der Praxis wird für jedes FLAT ein eigenes DARK erstellt, besser sogar mehrere und diese werden mit der Bildbearbeitungs-Software gemittelt. Jetzt dividiert man das korrigierte Rohbild durch das korrigierte FLAT pixelweise und multipliziert das Ergebnis mit dem Mittelwert aller Pixel aus dem FLAT. Das Ergebnis ist das erste korrigierte Bild. Dieses ist üblicherweise noch stark verrauscht. Um das Rauschen zu verringern werden mehrere Bilder erstellt und diese überlagert. Genauso wird nicht nur ein FLAT oder DARK verwendet, sondern mehrere und diese werden gemittelt. Bei der Erstellung von Farbbildern muss diese Prozedur für jeden Farbkanal durchgeführt werden. |

3. Grundzüge der digitalen BildbearbeitungBei der Bildbearbeitung geht es im wesentlichen um 2 Punkte: |

zu 1:

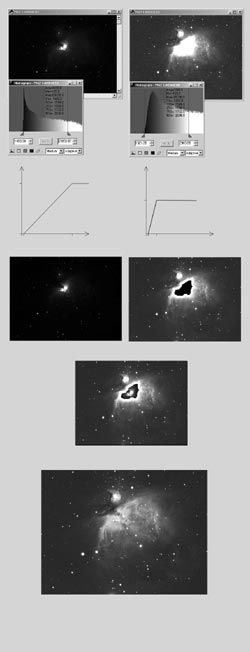

Abb. 18.1 ... 18.7 Die einfachste Möglichkeit ist hier den sogenannten Weiss- und Schwarzpunkt zu setzen. Bei einer CCD-Kamera mit einen 16 Bit AD-Wandler sind insgesamt 216 =65536 verschiedene Graustufen darstellbar (viel mehr als der Monitor darstellen kann). 0 bedeutet hierbei schwarz und 65535 weiss. Zeigt das Bild nun einen Grauschleier im Hintergrund, so kann dieser beseitigt werden, indem der Schwarzpunkt hin zu helleren Punkten verschoben wird. Wird der Schwarzpunkt beispielsweise auf 1500 gesetzt, so werden alle Pixel, deren numerischer Bildwert < 1500 ist auf schwarz gesetzt. In Abb. 18.1 wurde der Schwarzpunkt auf 1469 gesetzt; in Abb. 18.2 auf 1321. Abb. 18.1 ist daher auch merklich dunkler. Ähnlich verhält es sich mit dem Weisspunkt. Wird der Weisspunkt auf 10000 gesetzt, werden alle Pixel, deren numerischer Wert > 10000 ist auf weiss gesetzt. In Abb. 18.1 liegt der Weisspunkt bei 27328, bei Abb. 18.2 nur bei 4224: ein Grossteil des Bildes ist daher weiß. Die Abb. 18.3 und 18.4 zeigen das Beschriebene nochmals grafisch. Die Transformationskurve verläuft in 18.4 steiler und ist daher früher in der Sättigung. Die Steigung der Kurve ist ein Maß für den Kontrast. Hier zeigt sich, dass ein erhöhter Kontrast nicht nur Vorteile mit sich bringt. Zwar werden Details im Außenbereich sichtbar, dafür gehen aber Informationen im Zentrum verloren. Bis jetzt wurde nur die lineare Übertragungsfunktion und die beiden Grenzpunkte betrachtet. Insgesamt ist dies zwar eine Verbesserung gegenüber dem Rohbildern, aber zufriedenstellend ist das Bild immer noch nicht. Entweder werden die schwachen Details in den Außenbereichen sichtbar oder die sehr hellen Bereiche im Zentrum. Beides lässt sich mit dieser Methode des Weiss- bzw. Schwarzpunktes nicht erreichen. Die hier beschriebenen Korrekturen werden auch als Tonwertkorrektur bezeichnet. Ein weiterer Forschritt lässt sich erreichen wenn die Übertragungsfunktion nicht linear bleibt sondern die Form einer S-Kurve annimmt. Die Wirkung dieser Kurve ist in Abb. 19 gezeigt. Gestrichelt ist der lineare Weiss-/Schwarzpunktabgleich eingezeichnet. Die Kurve lässt sich wie folgt interpretieren: Der Anstieg der Kurve verläuft schwächer als bei einer Geraden, d.h., der Hintergrund wird dunkler gehalten und verläuft langsamer in die helleren Bereiche. Die beiden Pfeile (A) zeigen an, um wie viel ein entsprechender Graupunkt dunkler dargestellt wird. Im oberen Bereich werden die hellen Punkte angehoben. Die Interpretation ist analog zum unteren Punkt. Insgesamt führt die Gradationskurve zu einer Anhebung des Kontrastes und vermeidet einige Nachteile der vorher beschriebenen Bildbearbeitungsmöglichkeit. Insgesamt ist aber auch diese Methode nicht ganz befriedigend.  Abb. 19 Gradationskurve in Form eines S` Eine wirkliche Verbesserung bringt die Maskierungstechnik.Die Abbildungen 18.5 und 18.6 stellen nochmals die beiden Abbildungen 18.1 und 18.2 dar. Mit einem Unterschied: In die Abbildung 18.6 wurde der zentrale weisse und damit überbelichtete Teil ausgeschnitten. Es scheint der hier willkürlich gewählte schwarze Hintergrund durch. Wird nun unter die Abbildung 18.6 die Abbildung 18.5 gelegt (in Abb. 18.7 dargestellt), so scheint der dort gezeigte zentrale Teil des Orion-Nebels durch. Damit im später fertigen Bild die scharfen Kanten des Ausschnitts vom Auge nicht wahrgenommen werden, werden die Kanten weich gezeichnet, d.h. leicht unscharf gemacht. Die Abb. 18.7 ist sehr grob und soll auch nur das Prinzip darstellen. Verfeinert man dieses Technik auf 5 Ebenen mit einer feineren Abstufung erhält man ein Ergebnis wie in Abb. 18.8 gezeigt. Die Basis für dieses Bild ist eine einzige Aufnahme durch einen 100 mm Refraktor bei 640 mm Brennweite. Belichtet wurde nur 60 s! mit IR-Sperrfilter auf eine ST2000 von SBIG. In der Praxis "schneidet" man nicht die einzelnen Bildteile aus, sondern maskiert diese. Daher auch der Name Maskierungstechnik. Bis hierher wurde an den Bilddaten nichts grundlegendes verändert. Es wurden lediglich die Helligkeitswerte der einzelnen Bildelemente so angepasst, dass ein Maximum an Details wahrgenommen werden kann. Für photometrische Messungen können solche Bilder allerdings nicht mehr verwendet werden, weil die Linearität der Helligkeitswerte zu Gunsten eines optimalen Kontrastes aufgegeben wurde. |

zu 2:

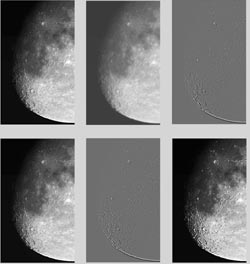

Abb. 20 Um ein vorhandenes Bild zu schärfen gibt es verschiedene mathematische Verfahren und Algorithmen. Die bekanntesten sind die unscharfe Maske und der Richardson-Lucy-Algorithmus. Mit beiden und weiteren von Software-Programmen angebotenen Verfahren ist der Autor nie glücklich geworden. Vermutlich deshalb, weil dem Anwender je nach Programm zwar Parameter zu Veränderung geboten werden, diese aber nicht beschrieben sind und es oft auf ein "Probieren" hinausläuft. Daher wird hier ein manuelles Verfahren der unscharfen Maske beschrieben, das generelle Gültigkeit hat: Ein Bild (Abb. 20 oben links) besteht aus einem scharfen und einem unscharfen Bildanteil. Wenn es nun gelingt den unscharfen Bildanteil zu bestimmen, so kann dieser vom Gesamtbild abgezogen werden und es bleibt der scharfe Bildanteil übrig. Die Kunst besteht nun darin diesen unscharfen Bildanteil zu bestimmen. Vorgehensweise: Im ersten Schritt wird von einem Bild ein Duplikat erstellt. Dieses wird dann weich gezeichnet bzw. unscharf gemacht. Dies ist ein Versuch den unscharfen Anteil künstlich zu erstellen bzw. zu simulieren. Von diesem Bild wird dann das Original subtrahiert. Es bleibt der Scharfanteil des Bildes übrig. In der oberen Bilderreihe der Abb. 20 ist dies dargestellt. Für das Weichzeichnen wird am besten der Gaußsche oder ein benutzerdefinierter Weichzeichner verwendet. Der einzugebende Parameter ist der Radius in Pixel; ein Maß für die Weichzeichnung. Sie ist abhängig von der Unschärfe des Original-Bildes und vom gewünschten Ergebnis. Im zweiten Schritt wird dann dieser Scharfanteil mit dem Originalbild verknüpft und als Ergebnis entsteht ein Bild erhöhter Schärfe wie in Abbildung 20 unten gezeigt. Bei dem scharfen Bildanteil handelt es sich hauptsächlich um Kanten, die hell dargestellt sind. Es liegt in der Funktion des Auges, dass Kanten besonders gut erkannt werden. Diese Eigenschaft des Auges sollte bei der Bildbearbeitung nie außer Acht gelassen werden. Über das Original-Bild wird ein (Relief-) Bild überlagert, bei dem die Kanten hervorgehoben sind. In Abb. 21 wird dies beim Sonnenrand sehr deutlich. Im vorigen Abschnitt siehe Abb. 18.7/18.8 lag die Kunst der Bildbearbeitung darin, dass die Kanten so unscharf gemacht werden, dass sie vom Auge nicht mehr wahr genommen werden können. Hier ist es umgekehrt! Ein Großteil der Aufgaben in der modernen Bildbearbeitung liegt darin entweder Kanten zu betonen oder diese unkenntlich zu machen. Bei all diesen Möglichkeiten sollten aber auch die Grenzen der Bildschärfung bedacht werden. Wird diese allzu unbekümmert eingesetzt entstehen Artefakte, also Muster die im Original nicht vorhanden sind. Dies ist aber nicht Sinn und Zweck der Bildbearbeitung. Dieser besteht darin vorhandene Details herauszuarbeiten und diese besser sichtbar zu machen.

Abb. 21

|

Glossar:Auflösunggibt an, daß sich zwei Punkte, die einen bestimmten Abstand voneinander haben, auflösen lassen, so daß sie einwandfrei zu unterscheiden sind. Binning ModeZur Erhöhung der Sensitivität besteht die Möglichkeit, ein Pixelbinning durchzuführen. Dies bedeutet, dass auf elektronischem Weg die Ladungsinformation eines 2 x 2 Pixel umfassenden Bereiches im Ausleseregister zusammengeführt werden. Der Dynamikbereich des Chips wird hierdurch nicht erhöht. Die Auslesegeschwindigkeit erhöht sich durch die geringere Anzahl auszugebender Pixel. Das Ausleserauschen wird hierdurch nicht erhöht. BloomingBlooming bezeichnet den Effekt, dass senkrechte oder waagerechte Streifen von hellen Sternen ausgehen. Dies tritt dann ein, wenn das einzelne Pixel mit Elektronen voll ist und die Elektronen in andere Pixel überlaufen. Der Effekt kann bei der Herstellung des Chips durch das Anbringen eines "Anti-Blooming Gates" zwischen den einzelnen Pixeln verhindert werden. CCDist die Abkürzung für Charge Coupled Device. Auf Deutsch heißt das ladungsgekoppeltes Bauelement. Verwendung finden sie hauptsächlich als Bildsensor bei Videokameras, Scannern und digitalen Fotoapparaten. Dark FrameBild zum Kalibrieren der eigentlichen Aufnahme. Das Dark Frame wird bei gleicher Temperatur und mit gleicher Beichtungszeit wie die Aufnahme erstellt. Allerdings bei geschlossenem Verschluss. Der Dunkelstrom und defekte Pixel sind im Dark und in der Aufnahme und können so ermittelt und beseitigt werden. Flat Field FrameBild zum Kalibrieren der eigentlichen Aufnahme. Bei dieser Aufnahme ist das Teleskop gegen eine homogen ausgeleuchtete Fläche gerichtet. Das Flat Frame zeigt die unterschiedlichen Empfindlichkeiten der einzelnen Pixel und die Vignettierung des optischen Systems an. Wird dieses Bild in die Aufnahme eingebunden, können die Fehler herausgerechnet werden. Full Well Capacity Der Wert gibt die maximale Anzahl an Elektronen an, die ein Pixel aufnehmen kann, bevor es gesättigt ist. Danach ist das Pixel "voll" und überschüssige Elektronen werden entweder über das Anti-Blooming Gate abgeleitet oder die Elektronen fließen in die Nachbarpixel und erzeugen die Blooming Streifen. MaskierenMit Masken werden Bildbereiche isoliert bzw. geschützt, während Farbänderungen, Filter oder andere Effekte auf den Rest des Bildes angewendet werden. Mit Masken werden Teile des Bildes vor der Bearbeitung geschützt. Masken sind für komplizierte Bildbearbeitungen verwendbar. Peltier-ElementEin Peltier-Element ist ein elektrisches Bauteil, das unter Spannung ein starkes Temperaturgefälle schafft. Das Peltier- Element [auch TEC = engl: Thermo Electric Cooler, genannt] ist eine Konstruktion aus zwei mit Kupferleitstellen verbundenen Halbleiterplatten auf Keramikbasis, die aufgrund ihres unterschiedlichen elektrischen Widerstandes einen Wärmeaustauscheffekt produzieren. Pixelist ein Kunstwort aus picture + element SamplingEin durch seine geometrischen Dimensionen (Länge x Breite in mm) definiertes Einzelpixel ist nicht für alle Teleskope gleich effektiv. Fällt das Beugungsscheibchen genau auf einen Pixel, ist die Empfindlichkeit optimal ausgenutzt. Das gesamte Licht eines Sternes fällt auf ein Pixel. Dafür sind die Sterne eckig und es fehlen Grauanteile im Bild: Dies wird Undersampling genannt. Ist nun die Brennweite des Teleskops so gewählt, dass das Beugungsscheibchen z.B. auf 20 Pixel fällt, so entsteht ein Grauverlauf des einzelnen Sterns und er wird schön rund. Die Kamera arbeitet aber sehr unempfindlich, weil sich das Licht eines einzigen Sterns nun auf sehr viele Pixel verteilt: Dies wird Oversampling genannt. Critical SamplingBei Planeten wird immer im Oversampling-Bereich gearbeitet. Für DeepSky-Aufnahmen muss ein optimaler Bereich zwischen Over- und Undersampling gefunden werden. Die Kamera muss noch empfindlich arbeiten, die Bilder sollen aber trotzdem fein abgestuft sein. Erfahrungswerte zeigen, dass eine Auflösung von 1 ...2 Bogensekunden pro Pixel optimal sind. Die beste Möglichkeit sich in diese Materie einzuarbeiten ist der Kontakt zu anderen Sternfreunden. Man erspart sich teilweise "tagelanges" probieren am PC. Sehr gut geeignet ist hier z.B. die Astronomie-Messe AME. Dort stellen auch viele Astronomie-Vereine aus, deren Mitglieder gerne Auskunft geben und Anfänger gerne unterstützen.

Die Sternwarte Weil der Stadt auf der AME, heftig wird über die neuesten Ergebnisse der Bildbearbeitung diskutiert.

|

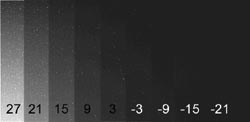

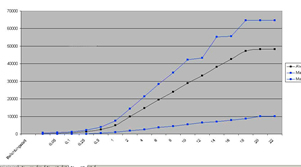

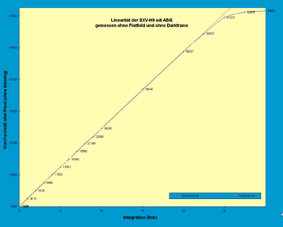

Nachtrag (Linearität von CCD-Kameras)

Linearität der ST-2000 CCD-Kamera von SBIG mit ABG: Download Linearität Excel Sheet

|

Farbempfindlichkeit der SBIG ST-2000 CCD-Kamera mit Filter

|

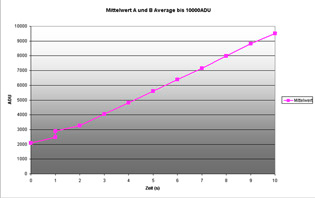

Messaufbau für Linearitätsmessung bei der SBIG ST-2000 CCD-Kamera Beschreibung der Messung:Die obere Abbildung zeigt den Messaufbau. Gemessen wurde hier gegen eine Kodak-Grey-Card. Im Prinzip ist dafür aber jede reproduzierbare Fläche geeignet. Zu achten ist auf homogene Lichtverhältnisse. Also nicht in einem Zimmer mit Fenster messen. Wechselnde Lichtverhältnisse von aussen (Sonne/Wolken), oder die einsetzende Dämmerung können das Messergebnis verfälschen (woher ich das wohl weiss...). Das Objektiv spielt nur eine untergeordnete Rolle. Die Fehler gleichen sich aus, da sie ja bei jeder Messung auftreten. Bei der Messung mit der kürzesten Belichtungszeit ist darauf zu achten, dass die Messung nicht im Rauschen untergeht. Im Zweifelsfall die ersten Werte besser weglassen. Die Software, hier CCD-Soft zeigt nun den Min., den Max. und den Mittelwert der Messung an. Der Mittelwert ist die Summe aller Pixelwerte, geteilt durch die Anzahl der Pixel. Diese Werte werden gegenüber der Belichtungszeit aufgetragen. Das Ergebnis kann dann in einer Excel-Tabelle ausgewertet werden. Zur Verblüffung konnte bis jetzt die immer wieder behauptete Nichtlinearität der ABG-Kameras nicht festgestellt werden. |

Linearität der Starlight SXV-Kamera mit ABG, gemessen von Herrn Rolf Apitzsch Herr Apitzsch schreibt dazu:

|

Linearität der Starlight SXV-H9Kamera mit ABG, gemessen von Martin Krahn Hallo, Siegfried! |

Fazit: CCD-Kameras mit Anti-Blooming Gate sind bezogen auf die Empfindlichkeit linear!